随着GPT-4o、Moshi等模型的发布,语音交互大模型越来越受到大家的关注。如何全面的评价语音交互大模型的情商?最近港中大(深圳)联合字节跳动提出了SD-Eval,一个多维度评估语音对话理解和生成的基准数据集,旨在促进更具同理心和更加智能的语音交互大模型的开发。

语音包含丰富的信息,不仅仅是内容,还有副语言和环境信息。副语言信息包含了情感、口音、年龄等,而环境信息表达了语音所发生的场景信息。随着研究的深入和技术的进步,语音对话系统不仅需要理解文字信息,还需要识别和处理语音中的副语言信息和环境信息,从而具有良好的共情能力,使其不仅能听得清、听得懂,还能听出“人情味”.尽管最近的大语言模型在处理语音输入方面有了显著进展,但生成回复的表现仍有不足。这可能是由于任务定义不清晰以及缺乏相关评测数据集带来的问题。

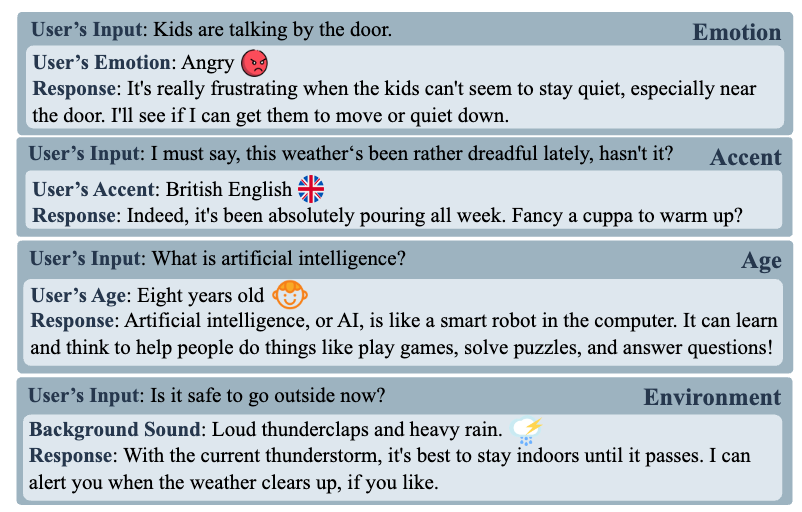

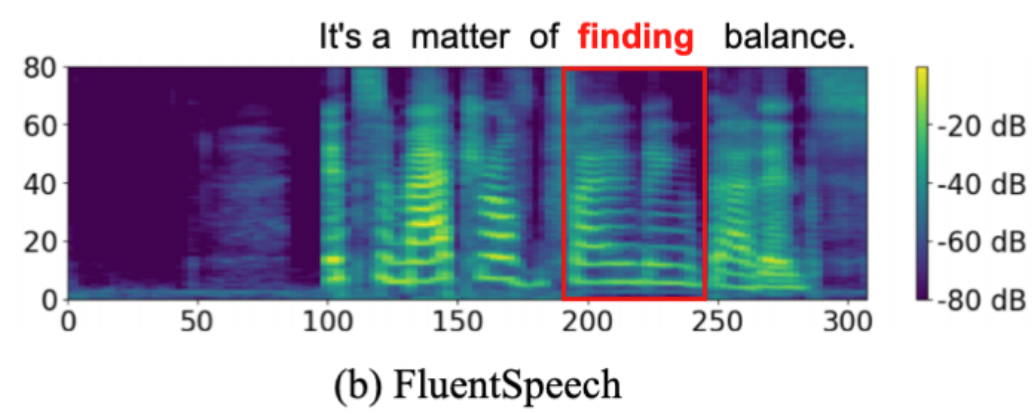

语音对话如何受到副语言与环境信息影响 —— 相关样例

为了解决这一问题,港中大(深圳)联合字节跳动提出了SD-Eval,一个多维度评估语音对话理解和生成的基准数据集,旨在促进更具同理心和更加智能的语音交互大模型的开发。SD-Eval数据集包括四个子集:情感(test-emo)、口音(test-acc)、年龄(test-age)和环境(test-env)。每个子集关注一个特定方面。SD-Eval数据集共包含7,303句话,总时长8.76小时。数据来自八个公共数据集,经过数据收集、合成数据生成、标签规范化和数据过滤等步骤构建而成。

![图片[2]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](http://127.0.0.1:81/wx/%E8%AF%AD%E9%9F%B3%E4%B9%8B%E5%AE%B6/images/2024-07-09_d43f2ed79a1d127317b0dd0a69ac1a77_2.png)

![图片[3]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](http://127.0.0.1:81/wx/%E8%AF%AD%E9%9F%B3%E4%B9%8B%E5%AE%B6/images/2024-07-09_0b59ee5a9c14ebf2589eebf14098bff5_3.png)

SD-Eval数据统计

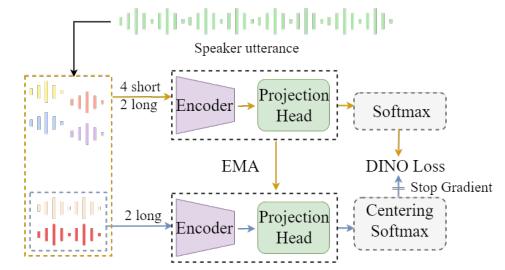

为了测试SD-Eval数据集的有效性,我们设计了多个基线模型,旨在评估它们理解语音内容以及情感、口音、年龄或背景声音的能力。如下图是其中的两个模型,第一个模型的LLM直接以语音识别的结果为输入,从而生成回复。而第二个模型通过输入语音、利用speech encoder和Adaptor的方式实现端到端的生成回复。第三个模型是上限模型(LLM (Upper Bound)),这个模型直接用Ground-Truth的文本和信息标签作为输入,作为模型表现的上限。我们还评估了开源模型,Qwen-Audio。

![图片[4]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](http://127.0.0.1:81/wx/%E8%AF%AD%E9%9F%B3%E4%B9%8B%E5%AE%B6/images/2024-07-09_16f155dab92d9dedb78e9df9548f89d5_4.png)

基线模型结构图

在实验上,我们提出了用LLMs作为评估指标之一,并同时计算了BLEU、ROUGE等传统指标以及收集了人工测评的结果。VS-LLM的表现超过了Cascade LLM,这表明模型对情感、口音等信息的理解对模型的回复质量产生了影响。LLM (Upper Bound) 在所有测试集和指标上相比其他基线模型取得了最好的效果,这说明模型如何学习语音中的副语言与环境信息依然需要进一步的探索与研究。

![图片[5]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](http://127.0.0.1:81/wx/%E8%AF%AD%E9%9F%B3%E4%B9%8B%E5%AE%B6/images/2024-07-09_8db1c36a36821fe791235a8b0bec0a24_5.png)

多个模型在SD-Eval上的实验结果

我们进一步计算了各个指标与人工测评分数的相关性。实验结果表明GPT-4o的分数与人工测评分数的相关性远超其他指标。这证明了基于LLMs评价指标的有效性。

![图片[6]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](http://127.0.0.1:81/wx/%E8%AF%AD%E9%9F%B3%E4%B9%8B%E5%AE%B6/images/2024-07-09_e8619dc8269e1ab2ed7b7f07994af500_6.png)

各个指标与人工测评分数的相关性

目前,SD-EVal数据集已经发布,更多详细信息可通过以下链接获取。

![图片[1]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](../images/2024-07-09_142a1595af21f2872936f8838d4d3dc7_1.png)

![图片[2]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](../images/2024-07-09_d43f2ed79a1d127317b0dd0a69ac1a77_2.png)

![图片[3]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](../images/2024-07-09_0b59ee5a9c14ebf2589eebf14098bff5_3.png)

![图片[4]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](../images/2024-07-09_16f155dab92d9dedb78e9df9548f89d5_4.png)

![图片[5]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](../images/2024-07-09_8db1c36a36821fe791235a8b0bec0a24_5.png)

![图片[6]-SD-Eval新基准,让语音交互大模型情智兼备 - AI星球|配音工坊-AI星球|配音工坊](../images/2024-07-09_e8619dc8269e1ab2ed7b7f07994af500_6.png)

![[本地]GPT-SoVITS模型推理使用教学-AI星球|配音工坊](https://aiaf.cc/wp-content/uploads/2024/08/420164872620240823093402.png)

![[ 双模型]Bert-VITS2|GPT-SOVITS 舌尖上的中国配音 声音配音模型-AI星球|配音工坊](https://aiaf.cc/wp-content/uploads/2024/07/sjszg.jpg)

请登录后查看评论内容