any2any多模态

自然打断和实时响应

one more thing

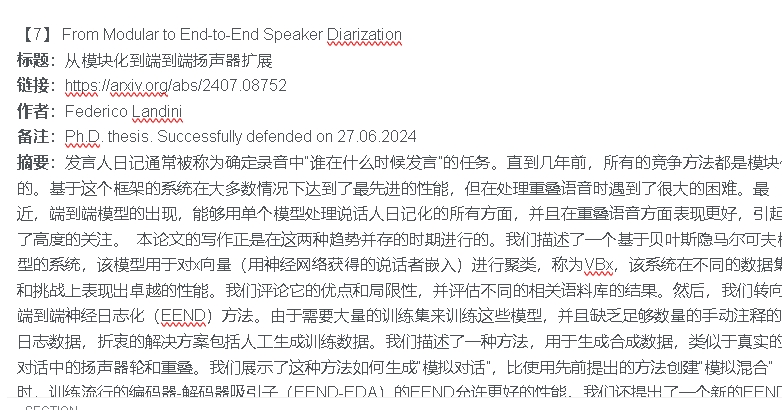

参考

-

whisper https://arxiv.org/abs/2212.04356 -

mms https://arxiv.org/abs/2305.13516 -

audioPaLM https://arxiv.org/abs/2306.12925 -

gpt4o https://openai.com/index/hello-gpt-4o/ -

moshi chat https://moshi.chat/ -

gmini https://arxiv.org/pdf/2312.11805 -

google astra https://deepmind.google/technologies/gemini/project-astra/ -

Speech ReaLLM https://arxiv.org/abs/2406.09569 -

BESTOW https://arxiv.org/abs/2406.19954

© 版权声明

本声音模型版权完全归属于声音者本人。本模型仅供个人娱乐学习使用,请您在下载后的24小时内妥善处理或删除。

THE END

![[本地]GPT-SoVITS模型推理使用教学-AI星球|配音工坊](https://aiaf.cc/wp-content/uploads/2024/08/420164872620240823093402.png)

![[ 双模型]Bert-VITS2|GPT-SOVITS 舌尖上的中国配音 声音配音模型-AI星球|配音工坊](https://aiaf.cc/wp-content/uploads/2024/07/sjszg.jpg)

请登录后查看评论内容